El primer despido de una IA

El algoritmo como excusa. El chatbot que se inventó una política de cancelaciones. Los riesgos de delegar tu atención al cliente en un LLM. Simetrías y responsabilidad.

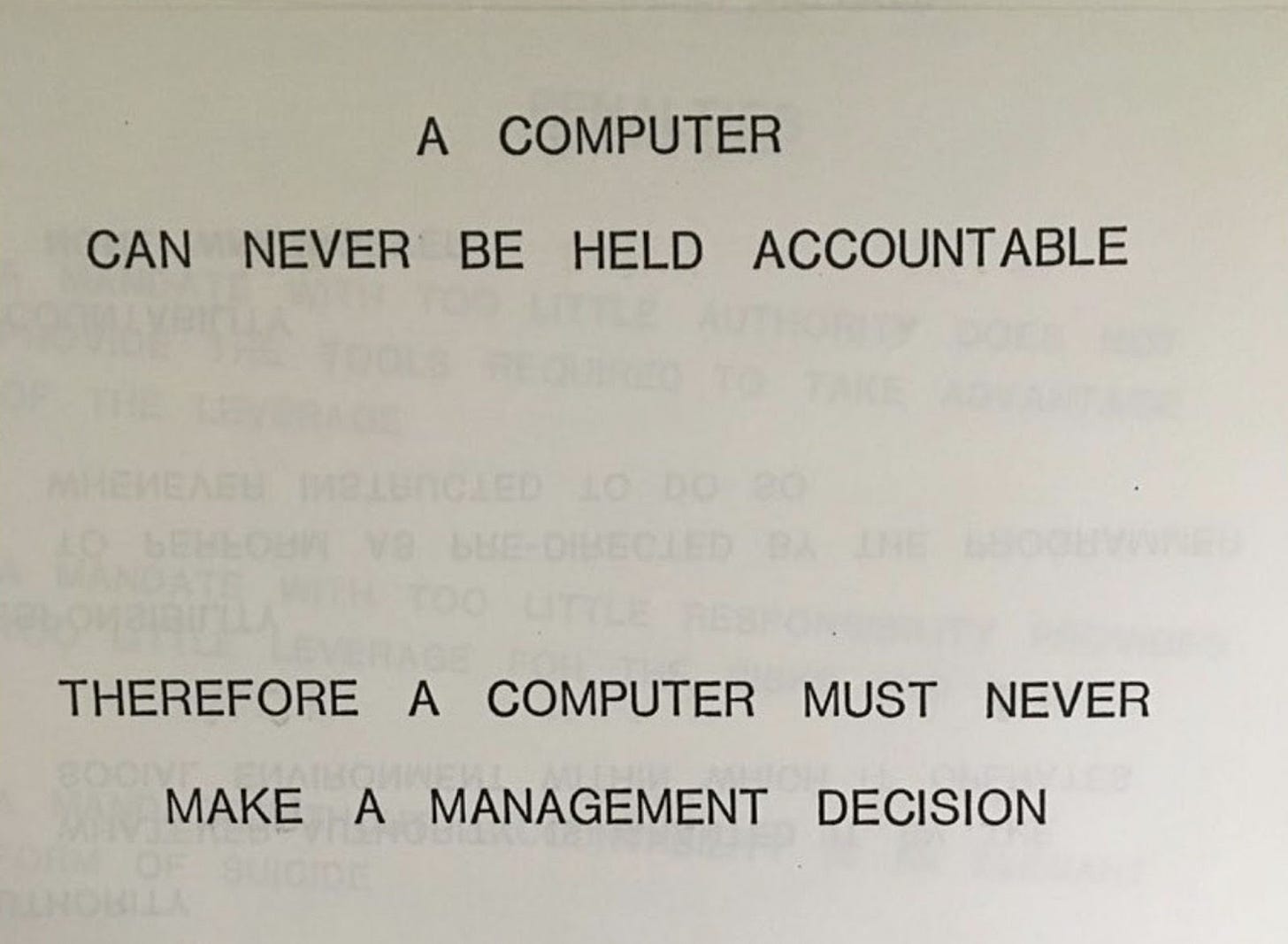

En 1979, un empleado de IBM usó esta diapositiva en una de sus presentaciones:

Parece lógico. Un ordenador, como ser inerte, no puede ser responsable de una decisión. Por lo tanto, nunca debería tomar una decisión de gestión.

Hoy en día, sin embargo, parece que las empresas le han dado la vuelta.

Como un ordenador no puede ser responsable, tiene que tomar todas las decisiones.

El algoritmo como excusa para lavarse las manos.

El algoritmo como excusa

Las redes sociales han abusado al extremo de este fenómeno. Sus algoritmos, basados en machine learning, son cajas negras que eligen qué contenido mostrar a cada usuario para maximizar su función de recompensa. Generalmente, que pasemos el mayor tiempo posible enganchados a la pantalla.

Para hacerlo, nos empujan constantemente a los extremos. A lo que genera polémica. A lo que nos enfada y nos mantiene dentro de su aplicación. Pero lo hace el algoritmo. No hay ningún ingeniero que haya programado explícitamente una función que empareje a usuarios con desórdenes alimenticios con contenido que lo fomente. No hay nadie con nombre y apellidos con las manos manchadas. Pero sucede.

La ciudad de New York presentaba esta semana una demanda en California contra Meta, Snap, Youtube (Google) y TitTok por fomentar una crisis de salud mental sin precedentes entre los jóvenes. El alcalde, Eric Adams, aduce que la ciudad gasta al año más de 100 millones de dólares en programas de recuperación orientados a adolescentes, y busca que las empresas tecnológicas asuman su parte de responsabilidad.

No es la primera demanda. No será la última.

De hecho, los principales ejecutivos del sector pasaron hace unas semanas por un comité del senado de EEUU dónde precisamente se trataban estos asuntos. La comparecencia de Zuckerberg, nos dejó uno de esos momentos que sólo se ven en EEUU, cuando uno de los senadores le pidió que se diera la vuelta para enfrentar, y pedir disculpas, a los padres de adolescentes afectados por las redes sociales, allí presentes.

La primera, y única vez, que había visto una escena similar fue viendo una serie sobre un asesino en serie en Netflix. Lo dejo ahí.

El chatbot que se inventó una política de cancelaciones

Otra historia curiosa de falta de asunción de responsabilidades esta semana, ha sido la condena a Air Canada a pagar un reembolso a un cliente, después de que su chatbot se hubiera inventado una política de cancelaciones que no existía.

¿La excusa de la aerolínea? El chatbot es una entidad legalmente independiente y, por lo tanto, responsable de sus propios actos.

According to Air Canada, Moffatt never should have trusted the chatbot and the airline should not be liable for the chatbot's misleading information because Air Canada essentially argued that ‘the chatbot is a separate legal entity that is responsible for its own actions,’ a court order said. -- Ars Technica

No sé qué hierba fuman en Air Canadá para llegar a juicio con semejante excusa, pero desde luego no ha pasado el filtro del juez y ha sentado un bonito precedente.

Un precedente no sólo legal, sino también conductual. Porque a raíz de esta noticia me imagino a decenas de miles de personas en todo el mundo tratando de hackear los chatbots de sus empresas favoritas, y no tan favoritas, para ver qué pueden conseguir sacar a sus agentes autónomos.

Y también me puedo imaginar a cientos de CEOs leyendo la noticia y ordenando apagar chatbots basados en IA como si no hubiera un mañana. El de Air Canada, por cierto, ya no se encuentra disponible. ¿Se podría considerar el primer despido de una IA?

La inteligencia artificial no es tan inteligente

El caso de Air Canada es un buen ejemplo de que las empresas despliegan productos sin tener mucha idea de ni como funcionan, ni de sus consecuencias.

Los Large Language Models, como Chat GPT o Google Gemini o Llama, son simples predictores de texto. Son capaces de predecir qué letras y palabras tienen que juntar para responder a tu consulta, pero no tienen ningún sentido lógico.

Son incapaces de saber si lo que están diciendo es real o inventado: literalmente, alucinan . No son deterministas: para una misma pregunta, pueden darte múltiples respuestas. Son explotables: sensibles a ataques de prompting que les puedan motivar a dar respuestas contrarias a las intenciones de la empresa.

En definitiva, son menos inteligentes de lo que pensamos. Y, a día de hoy, dejarlos sin supervisión humana, es algo muy arriesgado.

La responsabilidad donde corresponde

Volviendo a citar la presentación de IBM:

“A computer can be never held accountable, therefore a computer should never make a management decision.”

Las empresas, no las máquinas, son responsables de los sistemas que despliegan. Una red social es responsable del algoritmo que gestiona el engagement en su plataforma. Una empresa que despliega un agente de IA para responder a sus clientes, es responsable de sus palabras, y también de sus alucinaciones.

Está bien que Zuck tenga que acudir al senado y enfrentarse a los padres de adolescentes a los que las redes sociales han arruinado la vida. Está bien que Air Canada tenga que cumplir la promesa de su chatbot.

Emprender va de buscar asimetrías positivas. Sin embargo, en la relación empresa/cliente, si no hay cierta simetría, lo que nos encontramos es abuso.

Con la IA se está gestando el germen del abuso definitivo. Aquel donde agentes inteligentes actúen sobre partes importantes de nuestras vidas, delegándonos la responsabilidad a nosotros por usarlos.

No caigamos en la trampa. Exijamos poner la responsabilidad donde corresponde.

Buenoa reflexión como siempre Simon. Curiosamente recientemente me he unido a una empresa del sector aviación como director del "innovation lab" y estamos mirando la posibilidad de un asistente en aeropuertos. El caso de Air Canda es sin duda un aviso a los riesgos de que el IA sea el interlocutor con el cliente.