¿Por qué mis ingenieros no usan la IA?

¿Por qué mis equipos no producen pese a la aparición de la IA? Expectativas de los directivos frente a la realidad de las capacidades de los modelos del lenguaje actuales.

Me hace gracia cuando escucho o leo a algún CEO expresar su preocupación porque sus ingenieros no usan la IA. Me resulta gracioso porque demuestra una falta de contacto con la realidad bastante notable. Pensar que tus ingenieros no usan la IA es como pensar que no usan Google.

Lo que estos CEOs y directivos ansían en realidad que sus equipos produzcan más. Y se quejan amargamente porque, pese a la aparición de la IA, no perciben que su velocidad haya aumentado.

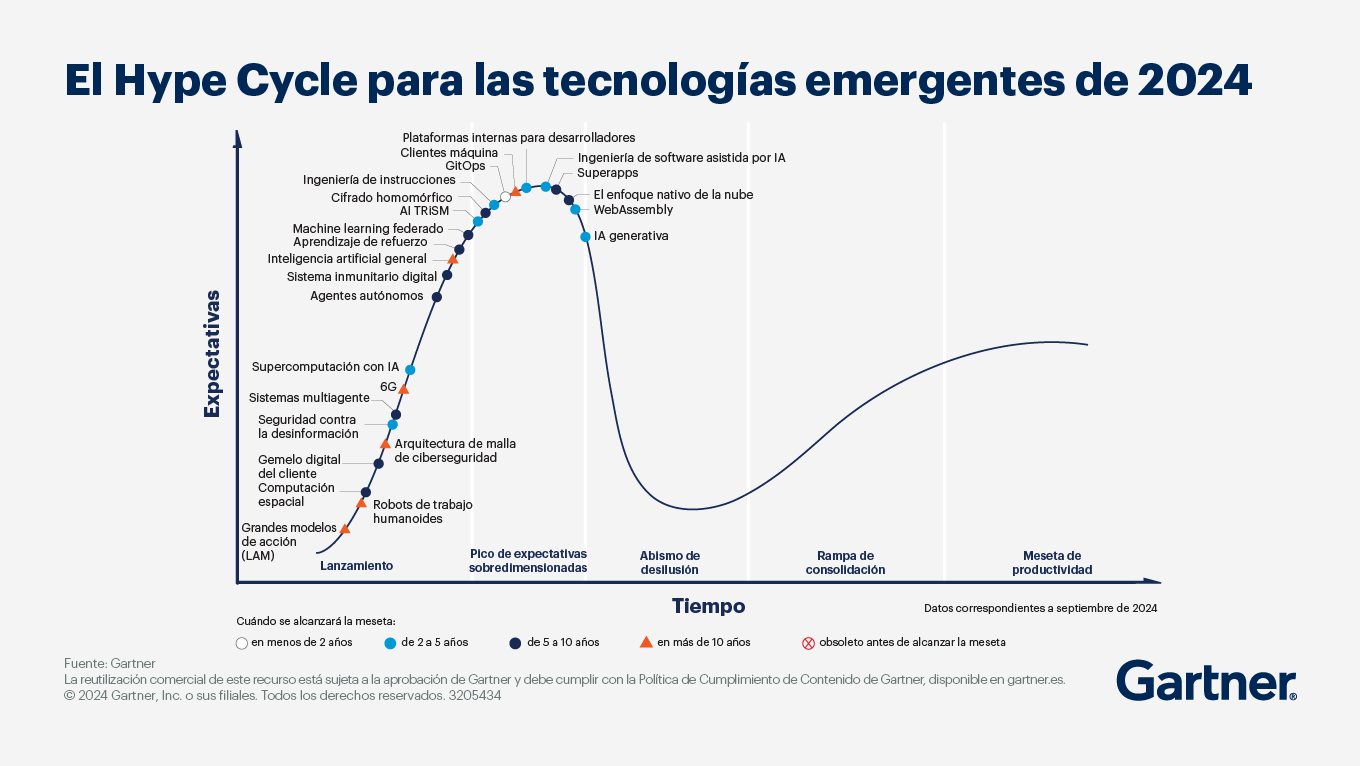

Parte del problema es la visión distorsionada que se tiene de las capacidades de la Inteligencia Artificial. Para ejecutivos, está literalmente en el pico más alto de las expectativas del Ciclo de Hype de Gartner sobre tecnologías emergentes.

Mientras tanto, los ingenieros, que ya llevan un tiempo experimentando con la IA, están empezando a entrar en la siguiente fase del ciclo de Gartner, el abismo de la desilusión.

Y es que, si bien la mayoría de ingenieros reconoce que la IA les ayuda a ser más productivos, especialmente con las tareas tediosas como la generación de documentación o cobertura de tests, cerca de un 50% considera que la IA responde mal ante problemas complejos.

Las razones para esto son variadas, pero tienen mucho que ver con la falta de contexto de las herramientas actuales sobre la base de código de las aplicaciones que soportan.

La IA actualmente funciona genial para resolver un problema que ya se ha resuelto mil veces y del que hay abundantes repositorios públicos, como podría ser construir cualquier aplicación web o interfaz sencillo.

Ese conocimiento genérico no deja de ser una “commodity”. Y no vale nada. El verdadero valor reside en el conocimiento del dominio específico del negocio que tiene la organización, y que queda lejos del corpus de aprendizaje de los LLMs comerciales.

Así, cuando un ingeniero trata de interactuar con un modelo del lenguaje para resolver un problema en su base de código del día a día, descubre que no puede confiar al 100% en las respuestas que le da, por lo que su aumento de productividad teórica desaparece conforme aumenta el tiempo que tiene que iterar para obtener la correcta.

Un paper publicado por Apple esta semana apoya lo que los ingenieros ya sabían. En The Illusion of Thinking, un equipo de investigadores en IA de Apple examinó la capacidad de resolver problemas según estos aumentaban de complejidad, observando que todos los modelos colapsan conforme esta supera cierto umbral.

La naturaleza no determinista de los LLMs tampoco ayuda. Puede que hagas la pregunta correcta a la primera, pero que fallen en respuestas posteriores. Y la realidad es que pocos procesos de negocio pueden absorber alucinaciones. Tu software de gestión de recursos humanos no puede alucinar cuando el usuario le pregunta cuántas horas trabajó Paco el mes pasado.

Resulta curioso que la frustración de los CEOs porque sus ingenieros utilicen más la IA, esté terminando al mismo tiempo con los ingenieros frustrados por verse obligados a utilizarla por obligación. Algunos comentarios en un hilo, “AI coding mandates at work?”, en el subreddit r/ExperiencedDevs recogen bien parte de esta:

At our monthly engineering all hands, they give us a report on our org’s usage of Copilot (which has slowly been increasing) and tell us that we need to be using it more. Then a few slides later we see that our sev incidents are also increasing.

Yeah, I tried GitHub Copilot for a while, and while some parts of it were impressive, at most it was an unnecessary convenience that saved only a few seconds of actual work. And it was wrong as many times as it was right. The time I spent correcting its wrong code I could have spent writing the right code myself.

Como pasó el del Blockchain, el de la web 3.0, el de las herramientas no code, y tantos otros, este ciclo de hype también pasará. Y cuando lo haga y los focos y la atención se vayan al siguiente, las empresas ganadaras serán aquellas que se hayan preocupado de generar una cultura sana de producto donde los ingenieros tengan autonomía para escoger las mejores herramientas para solucionar los problemas del negocio. Sean IA o no.

Buen artículo. Especialmente acertado el comentario sobre el decalaje que existe entre la percepción del CEO y la del CTO o el propio equipo de desarrollo. Aunque poco o nada ayudan los mil artículos de empresas hablando de casos de éxito cuando muchos de ellos no llegan ni a PoC.

De momento en mi equipo GitHub Copilot se ha demostrado muy útil. Aunque no la panacea.

Vamos a ver qué tal se comporta la nueva generación de IA, que sí debe trabajar sobre el contexto de tu propio código, y no sólo con corpus de proyectos externos. Nosotros comenzamos ahora a probar ese tipo de herramientas como el Agente de Copilot y otras herramientas de Vibe Coding. Pero aún es pronto para sacar conclusiones, más allá de confirmar que hay muchísimo hype.

Absolutamente de acuerdo!